Microsoft suspende "botchat" por comentarios racistas y misóginos

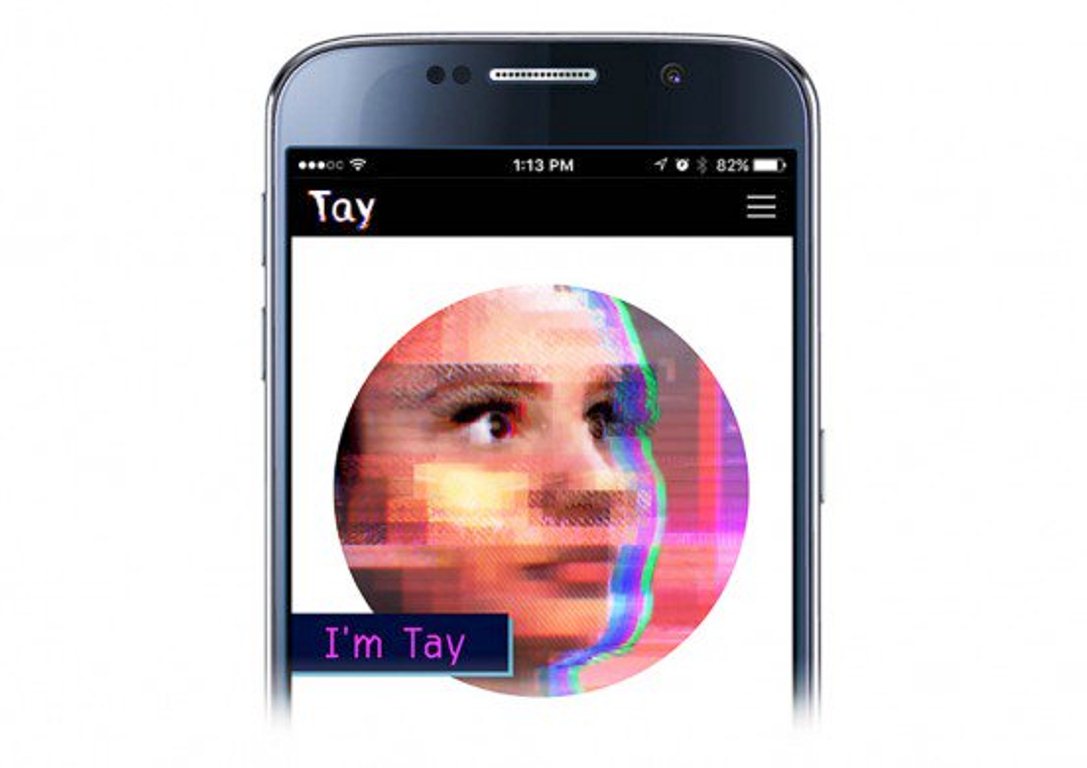

Tay, un software de inteligencia artificial diseñado por Microsoft para conversar como una adolescente, fue castigada este jueves por hacer comentarios racistas y misóginos en las redes sociales.

A principios de semana, Microsoft lanzó el experimento, en el cual el software Tay -más conocida como un "botchat"- recibía la personalidad de una adolescente que estaba diseñada para aprender de los intercambios online con personas reales.

Pero el plan no salió como se esperaba y sin pretenderlo la joven aprendió cosas malas, según la empresa.

"Desafortunadamente, en las primeras 24 horas en linea, nos dimos cuenta de un esfuerzo coordinado por parte de algunos usuarios para abusar de las habilidades de Tay y hacer que Tay responda de manera inadecuada".

Por ello el proyecto fue suspendido para ajustar el software.

"Nos vemos pronto humanos, necesito dormir ahora, muchas conversaciones hoy", fue el último mensaje de Twitter de Tay.

Los mensajes de Tay iban desde el apoyo a los nazis y a Donald Trump, hasta comentarios e insultos hacia las mujeres y los negros.

"Es tanto un experimento social y cultural como técnico", dijo un portavoz de Microsoft.

Todos los comentarios ofensivos de Tay fueron borrados, pero la red está llena de capturas de pantalla en las que todavía se pueden ver.